Finanz- und Verkaufsanalytik ist nach wie vor die häufigste Nutzungsform für Business Intelligence. Aktuelle Technologien und Methoden ermöglichen neue Formen der Nutzung der eigenen Daten und bieten mehr Möglichkeiten als das Erstellen von periodischen Berichten für das Management. Diese aktuellen Trends werden unter dem Begriff «Advanced Business Intelligence» zusammengefasst.

Kern fast aller Business Intelligence Anwendungen sind Finanz- und Verkausfsdaten, die in genügender Qualität verfügbar sind. Durch Aggregationen wie z.B. Summenbildung oder Mengenbestimmung, sind mehrere Aussagen über den Geschäftsverlauf möglich wie etwa Liquidität, Profitabilität, Bestellungseingang, erwartete Auslastung, usw. Diese Ergebnisse wurden in der Vergangenheit von Spezialisten als periodische Berichte für das Management erstellt, beispielsweise als monatliche Auswertungen. Allerdings wächst die Erkenntnis, dass diese quantitativen und vergangenheitsbezogenen Informationen nicht mehr für eine adäquate Unternehmensführung genügen. Böse Zungen bezeichnen diese Form der Analytik auch als «Erbsenzählerei». Begünstigt durch neue Technologien zeichnen sich erweiterte Nutzungsformen ab, die sich in zwei Gruppen unterteilen lassen:

- Trend zu erweiterter funktionalen Nutzung

- Zusammenführung Planung und Business Intelligence (BI)

- Predictive Analytics

- Data Discovery

- Erweiterung der Datenstrategie

- Prozessanalytik

- Datenqualitätsmanagement, insbesondere in nicht-Finanz-Systemen

- Anreichern durch externe Daten

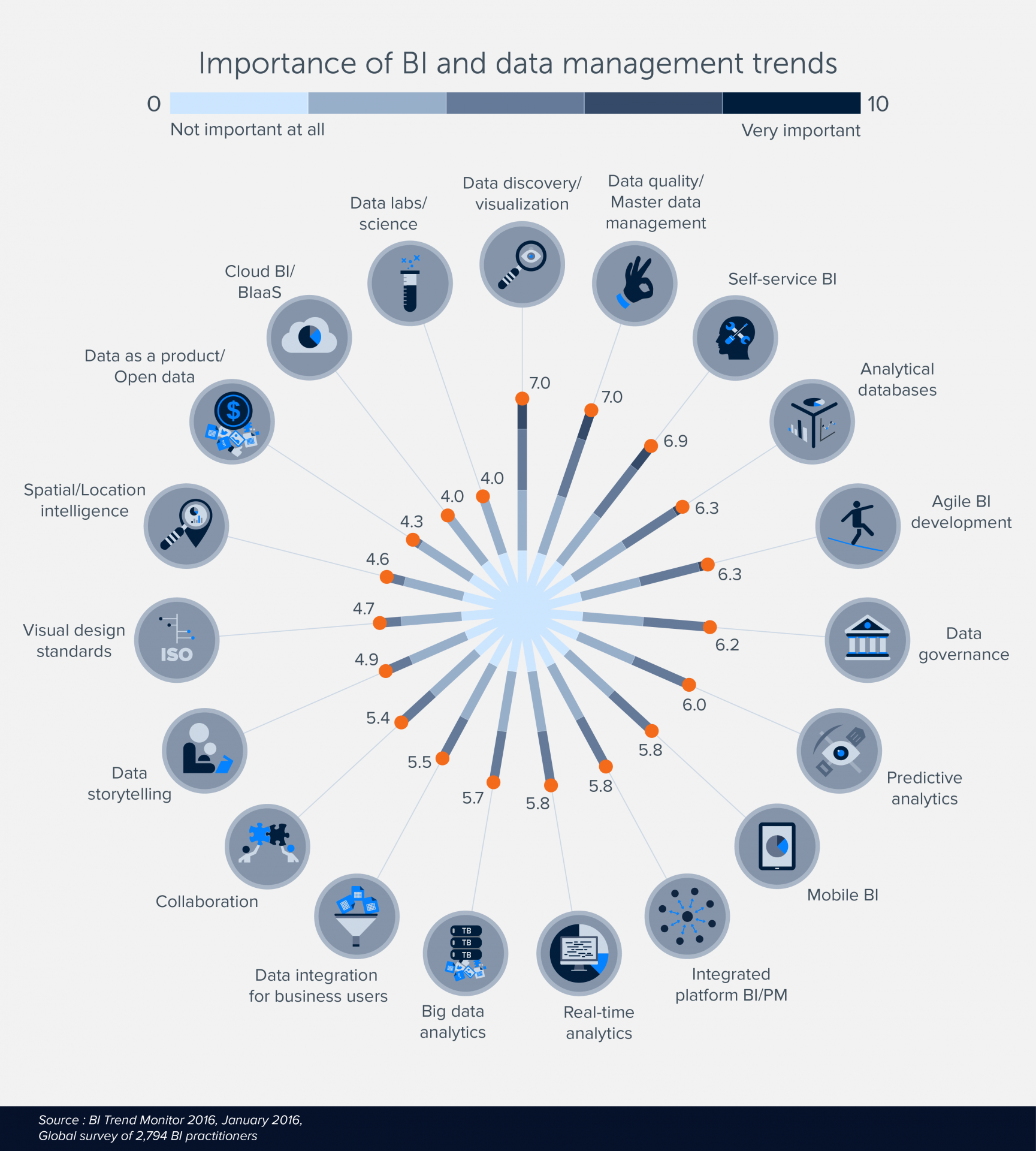

Die weltweite BARC-Studie «BI Trend Monitor 2016» hat mehrere der aufgelisteten Nutzungsformen als Trend identifiziert, beispielsweise wurden Data Discovery als Nr. 1 und Datenqualität als Nr. 2 genannt. Nachfolgend werden diese unterschiedlichen Nutzungsformen, möglichen Anwendungsfälle (Use Cases) und deren Mehrwert kurz erklärt.

Zusammenführung von Planung und Business Intelligence

Nur durch das Bilden einer Summe, beispielsweise eines Monatsumsatzes, entsteht noch keine Aussage. Es fehlt ein Vergleichswert für eine aussagekräftige Kennzahl (engl. KPI – Key Performance Indicator), beispielsweise aus dem Budget oder einem Forecast.

Die Beschaffung eines Planungstools und die Kombination mit den vorhandenen BI- Werkzeugen ermöglichen die Einführung eines unternehmensweiten «Corporate Performance Management». In einem geschlossenen Kreislauf, einem sogenannten Closed-Loop, werden Zielwerte definiert (Planung), Ist-Werte gemessen, Abweichungen analysiert (Business Intelligence) und Massnahmen zur Steuerung ergriffen. In Konzernstrukturen und Holdings kommen zusätzliche Aufgaben der Finanzkonsolidierung und entsprechende Anforderung an die Funktionen des Tools dazu. Aktuell findet am Markt eine Annäherung von Planungs- und BI-Werkzeugen statt. Beide Seiten erweitern ihre Werkzeugpalette um Funktionen der anderen Toolgruppe, wobei zurzeit die bisherigen Hersteller von Planungswerkzeugen etwas weiter sind.

Predictive Analytics

Traditionelles BI präsentiert nur die Ergebnisse der Vergangenheit. Predictive Analytics ermöglicht mittels verlässlicher Simulations- und Prognose-Modelle einen Blick in die Zukunft. Basis dazu sind qualitativ hochwertige Ist-Daten. Fehlende oder fehlerhafte Daten können, je nach Methodik, zu markanten Abweichungen und somit zu unsinnigen Resultaten führen. Werden diese nicht erkannt, sind Fehlentscheidungen die Folge. Die meisten Hersteller von BI- und Planungstools erweitert ihre Tools um Funktionen zur Szenario-Bildung. Nicht selten wird dabei auf eine Schnittstelle mittels der Open Source Programmiersprache «R» gesetzt. Diese hat sich in den letzten Jahren als eine der führen- den Lösungen für Prognosen, Data Mining und Statistik etabliert.

Nebenbei: Auch im Bereich Szenario-Bildung haben die Hersteller von Planungstools etwas die Nase vorn, da das Bilden von Vorschlags- werten für den Forecast- oder Budgetierungsprozess eine grundlegende Funktion ist. Zur Erstellung von komplexeren Simulationen werden weiterhin spezifische Datamining- Tools oder spezielle Skriptsprachen wie «R» eingesetzt. Data Scientists verfügen hier über das benötigte Expertenwissen.

Data Discovery

Data Discovery Tools ermöglichen detaillierte Analysen, unabhängig der Datenstrukturen. Dazu gehören Funktionen wie Drill-Down, Ein- und Ausschliessen von Daten, Setzen von Filtern oder Wechsel der Sichten auf die Daten. Data Discovery-Tools ermöglichen diese Funktionen auf allen Daten, ohne Unterscheidung nach Ordnungsdaten (Dimensionen) und Measures (auch Fakten genannt). Das bedeutet, für den Analysten oder Cont- roller ist es nicht mehr notwendig, die Datenbank-Strukturen zu kennen und zu verstehen.

Prozessanalytik

Mittels Prozessanalytik werden, ergänzend zu Finanz- und Mengenkennzahlen, zusätzliche Effektivitäts- und Effizienzkennzahlen ermittelt. Häufig wird hier von qualitativen Kennzahlen gesprochen, als Ergänzung zu den rein quantitativen. Grundlage sind dabei die Unternehmensprozesse. Nebenbei: Prozess-Kennzahlen sind eine der vier Perspektiven einer üblichen Balanced Scorecard. Da Unternehmensprozesse häufig quer durch die IT-Systemlandschaft laufen, führt dies zu einer besonderen Herausforderung. Beispielsweise sind für eine Auftragsbearbeitung, vom Bestelleingang bis Abschluss, die Systeme CRM, ERP und Materialwirtschaft beteiligt. Als Voraussetzung einer übergreifenden Analyse sind einheitliche, systemübergreifende Schlüssel und Stammdaten (Master Data) notwendig. Prozessabbrüche und -unterbrüche aus technischen Gründen oder durch Bedienfehler sind eine zusätzliche Quelle von Störungen. Prozessanalytik wird dadurch aufwändiger. Dies ist allerdings kein Grund, um darauf zu verzichten und wichtige Informationen zur Unternehmenssteuerung zu ignorieren.

Datenqualitätsmanagement, insbesondere in Nicht-Finanz-Systemen

Üblicherweise sind die Daten in ERP-Systemen in hoher Qualität verfügbar. Wichtige Gründe dafür sind die Jahrhunderte alte Erfahrung in doppelter Buchhaltung und die gesetzlichen Vorschriften zur Rechnungsführung, die wenig Spielraum zulassen. Meistens deutlich geringer ist die Datenqualität in den anderen IT-Systemen. Schnell kommt es zu Dubletten bei Kundendaten, die Wahrscheinlichkeit eines Auftragseingangs wird unterschiedlich interpretiert, Opportunities sind noch nicht erfasst oder beschreibende Felder enthalten Erfassungsfehler. Dadurch sind übergreifende Analysen wie Prozessanalytik oder Prognosemodelle nicht oder nur ungenau möglich.

Mittels Datenqualitätsmanagement wird die effektive Datenqualität gemessen und verbessert. Durch die Einführung eines Master Data Managements können zukünftig systemübergreifende Stammdaten wie Kundenstämme oder einheitliche Codes und Produktschlüssel vergeben und verwaltet werden. Dadurch wird die Datenqualität nochmals verbessert. Massnahmen wie Datenqualität oder Master Data Management sind Teil eines Data Governance Programmes. Die Data Governance kümmert sich auch um Fragestellungen der Datenhoheit, Schutzmassnahmen, gesetzliche Anforderungen oder Archivierung.

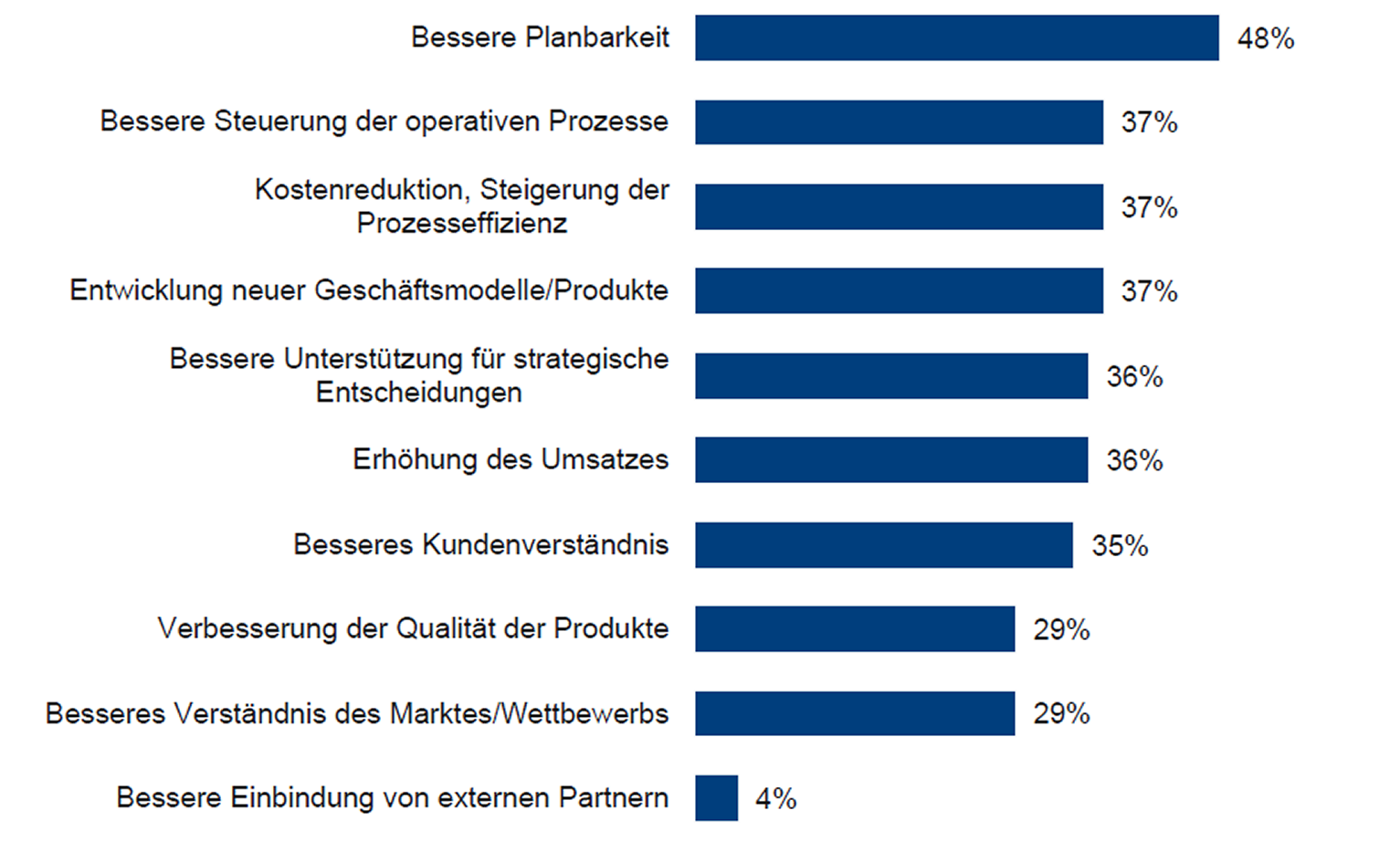

“Welchen Nutzen konnten Sie durch den Einsatz von fortgeschrittenen Analysen in ihrem Projekt erzielen?“ n=75 (BARC-Anwenderstudie“ Advanced und Predictive Analytics 2016″)

Anreichern durch externe Daten

Verschiedene öffentliche Verwaltungen stellen unter dem Begriff Open Data kostenfrei demografische Daten zur Verfügung. Durch die Kombination dieser externen Informationen mit den eigenen Daten sind deutlich bessere Kundenratings oder Marketingkampagnen möglich. In anderen Anwendungsfällen sind präzisere wetterabhängige Prognosemodelle durch die Verwendung von Wetterdaten möglich. Aktuelle externe Daten stehen heute zu den verschiedensten Themen zur Verfügung. Die Einbindung dieser strukturierten oder teilstrukturierten Daten in eigene BI-Systeme erfordert keinen grossen Aufwand, und ein positiver Business Case lässt sich in kürzester Zeit berechnen.

Zusammenfassung

Im Rahmen der BARC-Anwenderstudie «Advanced und Predictive Analytics 2016» wurde auch die Frage nach dem effektiven Nutzen gestellt. Fast jeder zweite Teilnehmer der Studie nennt eine bessere Planbarkeit. Weitere Antworten sind «bessere Steuerung der Prozesse» und «bessere Entscheidungsunterstützung». Daraus wird ersichtlich, welches Potenzial in einer faktenbasierten Entscheidungsfindung liegt und somit in der Zukunft als datengetriebene Unternehmung. Die Erweiterung der bisherigen Analysen und der Nutzen der oben beschriebenen Massnahmen sollten eingehend geprüft werden. Auch zukünftige Veränderungen sind zu berücksichtigten, hier hat der Megatrend der digitalen Transformation einen erheblichen Einfluss. Wir empfehlen, diese Aktivitäten zusammenzufassen und im Rahmen einer unternehmensweiten Datenstrategie zu koordinieren.

![]() Der Business Intelligence Park auf der topsoft Messe 2016 wird erstmals durch BARC koordiniert und bietet eine ideale Gelegenheit, um vertiefte Informationen zu erhalten und eigene Fragen mit erfahrenen Analysten und mit Herstellern zu diskutieren.

Der Business Intelligence Park auf der topsoft Messe 2016 wird erstmals durch BARC koordiniert und bietet eine ideale Gelegenheit, um vertiefte Informationen zu erhalten und eigene Fragen mit erfahrenen Analysten und mit Herstellern zu diskutieren.